Gain new perspectives for faster progress directly to your inbox.

Por qué un tamaño mayor no es necesariamente mejor con las herramientas de IA y las aplicaciones especializadas

Desde su lanzamiento en 2022, ChatGPT ha redefinido la conversación sobre la IA. Descrito a la vez como un milagro y una amenaza, sus posibles consecuencias parecen ir desde resultados positivos, como revolucionar el trabajo y revitalizar las ciudades, a efectos negativos como robarles el empleo a los humanos, y se dice que este modelo grande de lenguaje (LLM, Large Language Model) es capaz de prácticamente cualquier cosa.

¿Cuál es la diferencia entre ChatGPT y GPT-3/GPT-4?

Hay diferencias importantes entre ChatGPT y los grandes modelos de lenguaje, conocidos como GPT- seguido de un número (p. ej., GPT-3 o GPT-4). Con frecuencia, estos conceptos se confunden o se usan indistintamente, pero ChatGPT es la app de bot de chat con una interfaz “fácil de usar” que se ejecuta sobre los LLM, más complejos (GPT-3 o GPT-4).

GPT-3 y GPT-4 son versiones diferentes en una serie de modelos de transformadores generativos preentrenados. Los transformadores son un tipo de red neuronal que se conoce como modelos de lenguaje. Estos modelos pueden aprender a reconocer patrones y contextos en datos poco estructurados, por ejemplo, palabras contenidas en frases. Es una tarea que los transformadores hacen excepcionalmente bien. Un modelo generativo, cuando recibe un contexto, puede generar una salida arbitrariamente larga a partir de una solicitud. Los modelos GPT combinan estos dos tipos de modelos.

Por su parte, ChatGPT es la app que sirve como interfaz de grandes modelos de lenguaje como GPT-3 o GPT-4. Tiene un módulo de memoria para continuar conversaciones anteriores y cuenta con filtros, clasificadores y otras funciones integradas para minimizar las respuestas tóxicas o inadecuadas.

¿Qué hace falta para crear un LLM?

Los LLM son impresionantes. GPT-3 tiene 175 000 millones de parámetros o valores que el modelo puede cambiar de manera independiente a medida que aprende. GPT-4, la versión más reciente de la serie GPT, lanzado en 2023, es aún mayor y usa 1 billón de parámetros. Como cualquiera que los haya utilizado puede atestiguar, estos modelos tienen un conocimiento increíblemente amplio y una capacidad asombrosa de producir información coherente.

Sin embargo, estas capacidades tienen ciertos costes. Entrenar estos modelos GPT, cada vez más grandes, e implementar apps como ChatGPT es una gigantesca hazaña de ingeniería. Se estima que crear GPT-3 ha costado 4,6 millones de dólares y que gestionarlo en la nube cuesta al menos 87 000 dólares al año. Probablemente, desarrollar GPT-4 ha costado la friolera de 100 millones de dólares o más.

A estas cifras hay que sumarles los elevados costes del hardware y los recursos necesarios para mantenerlo funcionando y refrigerar los centros de datos. Los centros de datos pueden usar miles de millones de litros de agua y el aire acondicionado consume energía y contribuye a las emisiones, lo que obliga a las organizaciones a evaluar los costes y los beneficios de estas potentes herramientas. A causa de estos costes iniciales y operativos, los LLM son prohibitivamente caros para la mayoría de las empresas privadas, el mundo académico y las organizaciones del sector público y seguirán siéndolo a medida que los modelos crezcan y aumenten su potencia.

Las limitaciones de los LLM

Gracias a algunos componentes estructurales, los modelos de transformador capturan la relación existente entre diferentes entradas y, con la ayuda de una enorme cantidad de textos de muestra, los LLM modernos han desarrollado una gran capacidad de extraer la semántica general de un fragmento de texto y realizar un seguimiento de las relaciones existentes entre los elementos de texto. Los modelos generativos, como GPT-3, han ido un paso más lejos y han aprendido a hacer un seguimiento de esas relaciones tanto en la pregunta como en la respuesta. En muchos casos, los resultados son impresionantes. Podemos pedirle a ChatGPT que elija un número entre 0 y 100 o preguntarle si el colesterol es un esteroide y muy probablemente nos dará una respuesta correcta.

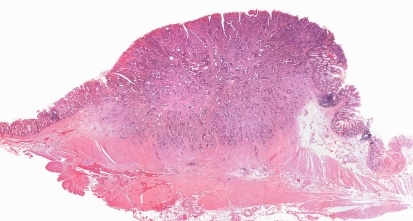

Sin embargo, para aplicaciones especializadas, como la investigación científica, los grandes modelos de lenguaje tienen dificultades para ir más allá de la semántica general y entender información específica con numerosos matices. ¿A qué se debe esto? En primer lugar, los LLM no son inmunes al problema de que "si entra basura, sale basura". En segundo lugar, incluso con datos de entrenamiento de alta calidad, es posible que la información de entrenamiento relevante no esté suficientemente representada.

Los LLM capturan bien los temas generales que se han descrito con frecuencia, pero los temas especializados con menos alcance suelen estar poco representados y su tratamiento es necesariamente más deficiente. Por ejemplo, un modelo de lenguaje grande puede llegar al nivel de abstracción adecuado y determinar si una molécula es un esteroide. Podría, incluso, reconocer dos moléculas de esteroides de la misma familia, pero no podría reconocer sistemáticamente si una de ellas es muy tóxica y la otra no. La capacidad del modelo grande de lenguaje para hacer esa distinción depende de los datos utilizados para entrenarlo y de si se ha reconocido y “memorizado” la información correcta. Si estaba oculta en un mar de información incorrecta o contradictoria, el modelo no puede determinar cuál es la respuesta acertada.

Cabría pensar que suministrar más datos que estén más limpios y crear modelos más grandes solucionará ese problema. Y es posible que sea así, pero ¿qué sucede si le pedimos a un LLM generativo que nos dé un número entre 0 y 100? ¿Podemos estar seguros de que el número elegido es realmente aleatorio? Para responder a esa pregunta, tenemos que ir más allá de la semántica léxica y los datos memorizados, más allá de los LLM, y acercarnos a los agentes de IA. El agente crearía un fragmento de código ejecutable usando procedimientos validados, se lo pasaría a otro proceso para que lo ejecutara, procesaría el resultado y presentaría la respuesta al usuario.

Desafíos específicos relacionados con los datos científicos

Como saben mis compañeros de CAS, los datos científicos pueden ser mucho más complejos que el texto y la mayoría de los problemas no se pueden expresar en una o dos preguntas.

Cuando usemos herramientas basadas en la IA para la investigación científica, debemos preguntarnos: ¿qué problema estamos intentando resolver? Muchos problemas tienen relación con secuencias de lenguaje o poco estructuradas, de manera que los modelos de lenguaje son una solución perfecta. Pero ¿qué sucede con los datos tabulares o de categorías, los gráficos de conocimiento y las series temporales? Estas formas de datos son necesarias para la investigación científica, pero los LLM no siempre son capaces de usarlas. Eso significa que los LLM, por sí mismos, no pueden proporcionar el nivel de especificidad necesario para una aplicación como la investigación molecular. Al igual que una orquesta necesita muchos instrumentos para crear un sonido cohesionado, la ciencia necesita múltiples herramientas en su caja de herramientas de IA para producir resultados coherentes.

Una estrategia de sistemas para aumentar la profundidad y el alcance

Si los LLM por sí solos no son adecuados para la investigación científica, ¿qué lo es? La respuesta es una estrategia de sistemas que use varios tipos de modelos para generar resultados especializados. Al complementar los modelos de lenguaje y las redes neuronales con herramientas tradicionales de aprendizaje automático, gráficos de conocimiento, quimioinformática y bioinformática, además de métodos estadísticos como TF-IDF, los investigadores pueden incluir información profunda y matizada en sus programas basados en IA.

Estas herramientas pueden proporcionar los resultados específicos necesarios para tareas como desarrollar nuevas moléculas de uso farmacológico o inventar nuevos compuestos. Los gráficos de conocimiento son especialmente valiosos porque actúan como referencia y conectan de manera fiable las entidades conocidas: una molécula, una reacción, un artículo publicado, un concepto controlado, etc. Un ejemplo de uso ideal es su utilización en una red neuronal profunda que pueda decir “Este es un tipo concreto de sustancia”, junto con un gráfico de conocimiento que valide la precisión. Es así como llegamos a los datos fiables imprescindibles para la investigación científica.

Este tipo de estrategia de sistemas es, en esencia, una función de verificación para mejorar la fiabilidad de los datos, y ya ha demostrado su eficacia en aplicaciones especializadas. Por ejemplo, Nvidia dio a conocer hace poco Prismer, un modelo de visión-lenguaje diseñado para responder a preguntas sobre imágenes o asignarles pies de fotos. Este modelo usa un enfoque de “mezcla de expertos” que entrena varios submodelos más pequeños. La profundidad del conocimiento obtenido con este modelo ha proporcionado resultados de calidad sin un entrenamiento excesivo: igualó el rendimiento de modelos entrenados con un volumen de datos 10 o 20 veces superior.

Google también usa un planteamiento similar, en el que el conocimiento se extrae de un modelo de lenguaje “profesor” de uso general y se introduce en modelos “alumnos” más pequeños. Los modelos alumnos proporcionan información de más calidad que el modelo más grande debido a la mayor profundidad de su conocimiento: un modelo alumno entrenado con 770 millones de parámetros presentó un rendimiento superior al de su modelo profesor con 540 000 millones de parámetros en una tarea de razonamiento especializada. Aunque entrenar el modelo más pequeño requiere más tiempo, las mejoras de eficiencia obtenidas son valiosas, ya que resulta más barato y más rápido ejecutarlo.

Mejorar la investigación científica

Otro ejemplo de éxito en la aplicación de la estrategia de sistemas es PaSE, el motor de semejanza de patentes que mis compañeros y yo hemos desarrollado en CAS, en el que se basan algunas funciones exclusivas de CAS STNext y CAS SciFinder. Creamos este modelo en el marco de nuestra colaboración con el Instituto Nacional de la Propiedad Industrial (INPI) de Brasil, que es la oficina de patentes del país. Se diseñó para procesar enormes cantidades de información en cuestión de minutos, lo que ha permitido a los investigadores hacer frente al enorme retraso acumulado en la tramitación de patentes.

La solución incluye un modelo de lenguaje que usa las mismas técnicas esenciales de aprendizaje automático que la familia GPT, pero añade otros tipos de aprendizaje, como los gráficos de conocimiento, la quimioinformática y los métodos estadísticos tradicionales de recuperación de información. Mediante el entrenamiento del modelo con la información científica del mundo, como las patentes de texto completo y las revistas incluidas en CAS Content CollectionTM, PaSE logró desarrollar el alcance y la profundidad necesarios para realizar búsquedas de estado de la técnica en la mitad de tiempo que los procedimientos manuales.

Para las oficinas de patentes, demostrar que algo no existe es enormemente complicado. Como se suele decir, “La inexistencia de pruebas no equivale a la prueba de la inexistencia”. Nuestros especialistas en datos entrenaron y optimizaron el modelo en colaboración con expertos en la búsqueda de patentes, con el equipo del INPI brasileño y con una combinación única de herramientas de IA que identificaron las patentes ya existentes con un 40 % menos de búsqueda manual. Por su rendimiento y por la reducción lograda en el retraso de la tramitación de patentes, fue galardonado con el Premio al impacto empresarial Stu Kaback por el Patent Information Users Group en 2021.

El futuro de los grandes modelos de lenguaje en la ciencia

Esta experiencia demuestra que los LLM seguirán desempeñando un papel importante en la investigación científica en el futuro, pero, contra la creencia popular, esta herramienta no es una panacea para todos los problemas o preguntas.

Suelo comparar estos modelos con organizar una habitación desordenada de una casa, como un armario o un desván. Probablemente, distintas personas organizarán lo que hay en esas habitaciones de maneras diferentes. Una persona puede ordenarlo todo por colores, mientras que otra agrupará los objetos valiosos y una tercera los clasificará por función. Ninguna de estas estrategias es errónea, pero es posible que no proporcionen el tipo de organización que se busca o se necesita. Este es esencialmente el problema con los LLM, que organizan la información de una forma concreta, pero puede no ser la que necesita un científico o un investigador.

En aplicaciones especializadas en las que un usuario necesita un resultado específico, como secuencias de proteínas, información de patentes o estructuras químicas, los modelos basados en la IA se deben entrenar para organizar y procesar la información de maneras concretas. Deben poder organizar los datos, los resultados y las variables como deseen sus usuarios para optimizar el entrenamiento y las predicciones.

Para obtener más información sobre el impacto de esos datos, sobre su representación y sobre los modelos que están mejorando las predicciones en el ámbito científico, lea los casos prácticos disponibles en CAS Custom Services. ¿Desea saber más sobre el panorama emergente de la IA y la química? Lea nuestro informe técnico más reciente sobre las oportunidades que la IA abre en el campo de la química o explore nuestros recursos sobre el papel de la IA en la mejora de la productividad de las oficinas de patentes de todo el mundo.